Ben je geïnteresseerd in de wereld van wetenschap & technologie en wil je hier graag meer over lezen? Word dan lid van KIJK!

Onderzoekers hebben een AI-model ontwikkeld dat audiofragmenten van steden kan omzetten in afbeeldingen die de werkelijke stadslandschappen verrassend nauwkeurig weergeven.

Als je een geluidsfragment te horen krijgt, is redelijk goed in te schatten hoe een bijpassend beeld eruit zou moeten zien. Bij insectengeluiden denk je bijvoorbeeld aan veel groen en door verkeersgeluiden beeld je je al snel een drukke straat in. Het is onderzoekers van de University of Austin in Texas nu gelukt om AI via ditzelfde principe gedetailleerde beelden te laten maken, die ook nog eens ongelooflijk goed kloppen.

Lees ook:

- Dit AI-radiostation speelt alleen maar neppe nummers

- Algoritme vindt acht ‘verdachte’ buitenaardse signalen

Beelddenker

De onderzoekers maakten gebruik van YouTube-video’s van steden in Noord-Amerika, Azië en Europa. Ze koppelden negenduizend schermafbeeldingen aan audiofragmenten, afkomstig van deze video’s, en voerden die aan een AI-model dat zo getraind werd om bepaalde geluiden met specifieke omgevingen te associëren. Vervolgens vroegen ze het model om beelden te genereren die zouden passen bij maar liefst honderd nieuwe audiofragmenten.

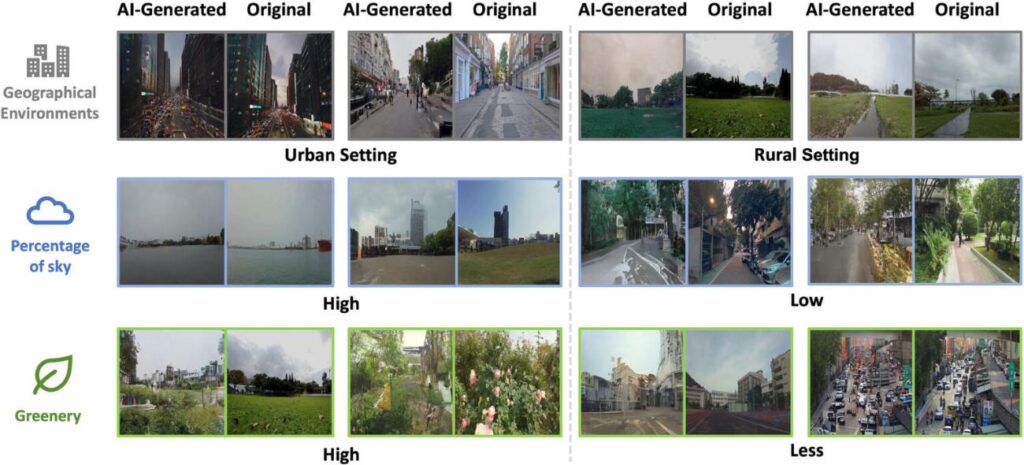

Zowel mensen als computerprogramma’s werden gebruikt om de originele beelden te vergelijken met de fakes. Er werd hierbij gekeken naar de verhouding van groen, gebouwen en lucht tussen beide afbeeldingen. Ook kregen de menselijke juryleden de opdracht om uit drie gegenereerde beelden de juiste te kiezen en te koppelen aan de bijpassende audio.

Spiegelbeeld

Uit het onderzoek bleek dat AI verassend goed scoorde bij het namaken van de juiste visuele elementen. De gegenereerde beelden vertoonden sterke overeenkomst met de werkelijkheid: de proporties van de lucht kwamen voor 80 procent overeen, en de hoeveelheid groen werd voor 69 procent correct weergegeven. Voor gebouwen was de overeenkomst iets minder nauwkeurig, met een score van 59 procent. Toch wist het model de essentie van een straatbeeld vaak treffend vast te leggen, zoals te zien is in de afbeelding hieronder.

Ook de menselijke jury had het vaak bij het juiste eind: in vier op de vijf gevallen selecteerde deze het correcte bijpassende beeld.

Stadsplanning

Yuhao Kang, assistent professor Geografie en Milieu en co-auteur van het onderzoek, wil het model verbeteren met Reinforcement Learning, waarbij het op basis van menselijke feedback leert om beelden te genereren die niet alleen beter aansluiten op de daadwerkelijke omgeving, maar ook op hoe mensen deze waarnemen en interpreteren. Daarnaast wil hij met zijn collega’s het onderzoek uitbreiden door naast de lucht, natuur en gebouwen ook andere straatelementen, zoals mensen en auto’s, mee te nemen.

De onderzoekers willen met hun werk meer inzicht bieden in hoe mensen omgevingsgeluiden waarnemen en hoe dit bijvoorbeeld van invloed kan zijn op onze mentale gesteldheid. Ook hopen ze dat hun onderzoek in de toekomst stadsplanners kan helpen om stedelijke landschappen beter af te stemmen op hoe geluid de ervaring van de bewoners vormgeeft.

Bronnen: ScienceDirect, UT News, NewAtlas

Beeld: Luke Stackpoole/Unsplash